CAD / GIS-plattformar måste gå till GPU

De av oss som använder grafiska applikationer förväntar oss alltid att datorerna har tillräckligt med arbetsminne. I detta har CAD / GIS-program alltid ifrågasatts eller mätts utifrån den tid det tar att utföra dagliga aktiviteter som:

- Rumslig analys

- Rättelse och registrering av bilder

- Utplacering av massiva data

- Datahantering inom en geodatabas

- Datatjänst

Den traditionella datorn har inte förändrats mycket de senaste åren, vad gäller RAM, hårddisk, grafikminne och funktioner som bara har ökat; men CPU: s operationslogik har behållit sin ursprungliga design (Det är därför vi fortsätter att ringa honom CPU). Det har också varit en nackdel att när team växer i kapacitet, dödar program deras förväntningar genom att utforma sig själva för att konsumera ny potential.

Som ett exempel (och endast exempel) När två användare är placerade på samma gång under samma betingelser av utrustning och data, en AutoCAD 2010 och ett med Micro V8i, loading 14 rasterbilder, en parcelario fil 8,000 egenskaper och anslutning till en spatial databas Oracle, vi ställer frågan:

Vad har en av de två för att inte kollapsa maskinen?

Svaret är inte innovation, det är helt enkelt hur programmet utvecklas, för så är inte fallet med AutoDesk Maya, som gör galnare saker och presterar bättre. Sättet att utnyttja datorn är detsamma (hittills i fallet med de två programmen), och baserat på detta skjuter vi programmen eftersom vi använder dem för att arbeta och mycket. Således är vissa datorer kända som traditionella datorer, arbetsstationer eller servrar; inte för att de har en annan färg utan för hur de kör program med hög förbrukning inom grafisk design, videobearbetning, applikationsutveckling, serverfunktioner och i vårt fall drift med rumsliga data.

Mindre CPU, mer GPU

Av de mest framstående nyligen gjorda förändringar i PC-arkitekturen är termen som GPU, (Graphics Processes), vilket gör det möjligt att hitta en bättre prestanda hos laget, konvertera stora rutiner till små samtidiga uppgifter utan att gå igenom administrationen av CPU (Central Processing Unit), vars arbetsförmåga spelas mellan rotationerna på hårddisken, RAM-minnet, videominnet och bland annat uppgifter (inte många andra).

Grafikkort är inte gjorda för att öka videominnet, utan innehåller snarare en processor som innehåller hundratals kärnor utformade för att köra parallella processer. Detta har de alltid haft (om), men den nuvarande fördelen är att dessa tillverkare erbjuder en viss öppen arkitektur (nästan) så att programutvecklare kan överväga att det finns ett kort med dessa funktioner och utnyttja dess potential. PC Magazine i januari nämner företag som nVidia, ATI och andra som ingår i alliansen OpenCL

För att förstå skillnaden mellan CPU och GPU, här hänvisar jag till en simulering:

CPU, alla centraliseradeDet är som en kommun med allt centraliserat, som har stadsplanering, den vet att den måste kontrollera sin tillväxt men kan inte ens övervaka de nya konstruktionerna som bryter mot normerna. Men istället för att bevilja denna tjänst till privata företag, insisterar han på att ta rollen, befolkningen vet inte vem man ska klaga på om grannen som tar trottoaren, och staden fortsätter att bli mer orolig varje dag.

Tyvärr pratade du inte om din borgmästare, bara pratade om en simulering av CPU, där denna centrala processenhet (i fall av Windows) skulle göra laget utföra i processer som:

- Program som körs när Windows startar, som Skype, Yahoo Messenger, Antivirus, Java Engine, etc. Allt förbrukar en del av arbetsminnet med låg prioritet men i onödan såvida det inte ändras av msconfig (som vissa ignorerar).

- Tjänster som körs, som ingår i Windows, vanligt förekommande program, ansluten hårdvara eller andra som avinstallerats men som fortfarande finns där. Dessa har vanligtvis en medel / hög prioritet.

- Program som används, som förbrukar utrymme med hög prioritet. Vi känner deras körningshastighet i vår lever eftersom vi förbannar om de inte gör det snabbt trots att de har ett högpresterande team.

Och även om Windows gör sin jonglering, har praktik som att många program öppnas, installeras eller avinstalleras oansvarigt, onödiga ämnen som ses pintones, de gör oss skyldiga till funktionsfel i utrustningen.

Det händer då att när vi börjar en process av de som nämnts i början kommer processorn att konkurs kokosnoten vill prioritera detta framför andra program som används. Dina få alternativ för att optimera är RAM-minnet, videominnet (som ofta delas), om det finns ett grafikkort, få ut något av det, beroende på vilken typ av hårddisk och andra bagateller, kan den ynkliga stönen vara mindre.

GPU, parallella processer, Det är som att kommunen beslutar att decentralisera, ge koncession eller privatisera de saker som är utom räckhåll för att de, även om de är stora processer, levereras i små uppgifter. Baserat på gällande bestämmelser får ett privat företag således rollen att specifikt övervaka straffbara överträdelser. Som ett resultat (bara exempel) kan medborgaren uppfylla det här läckra nöjet att berätta revbenen till grannen som tar ut hunden cagarse på sin trottoar, som bygger en vägg genom att ta en del av trottoaren, som parkerar sin bil felaktigt etc. Företaget svarar på samtalet, går till platsen, behandlar åtgärden, tar det till domstol, verkställer böterna, hälften går till kommunen, det andra är ett lönsamt företag.

Så här fungerar GPU, programmen kan utformas så att de inte skickar massiva processer på konventionellt sätt, men de går parallellt med små filtrerade rutiner. Oh! underbart!

Hittills är det inte många program som gör sina applikationer med dessa funktioner. De flesta av dem strävar efter att nå 64 bitar för att lösa deras långsamma problem, även om vi alla vet att Don Bill Gates alltid kommer att gå i dessa kapaciteter genom att ladda onödiga saker på nästa versioner av Windows. Windows strategi inkluderar att utnyttja GPU genom API: er som är utformade för att fungera på DirectX 11, vilket säkert kommer att vara ett alternativ som alla (eller de flesta) kommer att acceptera eftersom de föredrar det som en standard istället för att göra galna saker för varje märke utanför OpenCL.

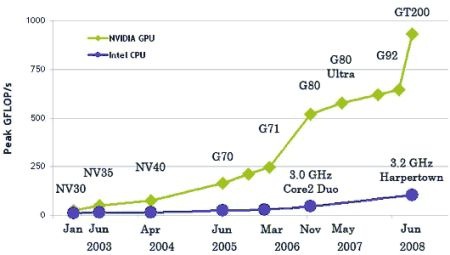

Grafen visar ett exempel som visar hur nVidia-processorn via GPU har revolutionerat sina funktioner mellan 2003 och 2008 jämfört med Intel CPU. Även rökt förklaring av skillnaden.

Men GPU: s potential finns där, förhoppningsvis och CAD / GIS-program får nödvändig juice. Det har redan hörts, även om det mest framstående fallet är d

e Manifold GIS, med CUDA-kort, från nVidia, där en process för generering av en digital terrängmodell som tog mer än 6 minuter utfördes på bara 11 sekunder och utnyttjade förekomsten av ett CUDA-kort. Rökte vad som gjorde dem vinna Geotech 2008.

Sammanfattningsvis: Vi går till GPU, vi kommer säkert att se mycket de närmaste två åren.

Hej Vicente, jag ser att du verkar bli van vid Windows 7.

Finns det något du saknar om xP?

Finns det anledningar till att jag inte skulle gå tillbaka till XP?

Windows 7 i 64bit låter dig fortfarande installera applikationer i 32bit ... Och hittills slutade inga av mina GIS-applikationer fungera.

"Förresten, har du testat Manifold på 64-bitars?"

Nup…. Även om min ödmjuka dator har en 64-bitars AMD, ville jag inte installera Windows 64 eftersom en stack med applikationer och drivrutiner skulle vara ur bruk. Jag tror att steget skulle vara att ha en dedikerad dator och installera allt i 64 bitar.

Jag tvivlar inte på att Manifold skulle vara en av de applikationer som skulle göra skillnaden i 64-bitar, och skulle inte vara enbart anpassning men de skulle få saften (som de gjorde med CUDA GPU-tekniken).

Tack för Gerardo data. Förresten, har du provat Manifold i 64 bitar?

God not

Om du vill se demonstrationsvideon av Manifold där du kan se plattans brutala bearbetningshastighet med CUDA-teknik - som dessutom flera kan installeras parallellt och därmed lägga till sina krafter, så länge det finns lediga platser - gå till denna YouTube-URL :

http://www.youtube.com/watch?v=1h-jKbCFpnA

En annan böna för Manifolds historia: 1er native 64 bit SIG program. Och nu, 1er SIG i att använda CUDA-tekniken ..

hälsningar